Minimax 01: Разблокировка обработки длинного контекста в 4M токенов для разработчиков ИИ

Понедельник, 15 января 2025 Автор: Ethan Chueng

Введение

Ландшафт ИИ развивается с невероятной скоростью, и MiniMax, ведущая компания в области ИИ, снова расширила границы с выпуском своей последней серии — MiniMax-01. Эта инновационная серия включает две модели: MiniMax-Text-01, базовую языковую модель, и MiniMax-VL-01, мультимодальную модель визуального языка. Эти модели предназначены для обработки сверхдлинных контекстов и сложных мультимодальных задач, устанавливая новые стандарты возможностей ИИ.

Серия MiniMax-01 — это не просто очередное постепенное улучшение; она представляет собой смену парадигмы в том, как модели ИИ обрабатывают информацию. С такими инновациями, как Lightning Attention и Mixture of Experts (MoE), Minimax достигла того, что многие считали невозможным: эффективной обработки контекстов до 4 миллионов токенов, значительно превосходя возможности ведущих моделей, таких как GPT-4o и Claude-3.5-Sonnet.

Этот блог предназначен для разработчиков ИИ, предлагая глубокий анализ технических инноваций, тестов производительности и практических применений серии MiniMax-01. Независимо от того, создаете ли вы ИИ-агентов, разрабатываете мультимодальные приложения или исследуете обработку длинного контекста, эта серия — инструмент, который нельзя игнорировать.

Модель Minimax 01

Обзор модели

Серия MiniMax-01 — это свидетельство приверженности Minimax инновациям. Вот краткий обзор двух моделей:

1. MiniMax-Text-01: Языковая модель, оптимизированная для обработки сверхдлинного контекста, способная обрабатывать до 4 миллионов токенов во время вывода.

2. MiniMax-VL-01: Мультимодальная модель, сочетающая визуальное и языковое понимание, обученная на 512 миллиардах визуально-языковых токенов.

Ключевые инновации:

- Lightning Attention: Инновационный механизм, который снижает вычислительную сложность внимания с квадратичной до линейной, позволяя эффективно обрабатывать длинные последовательности.

- Mixture of Experts (MoE): Гибридная архитектура с 456 миллиардами параметров, из которых 45,9 миллиарда активируются на каждый токен, обеспечивая высокую эффективность и масштабируемость.

Технический глубокий анализ

Lightning Attention

Традиционные модели Transformer борются с длинными последовательностями из-за их квадратичной сложности. Lightning Attention от Minimax решает эту проблему, разделяя вычисление внимания на внутриблочные и межблочные операции, сохраняя линейную сложность.

Эта инновация позволяет модели эффективно обрабатывать 4 миллиона токенов, что является достижением, недоступным для конкурентов.

Гибридная архитектура

Модель чередует слои Lightning Attention и традиционные слои SoftMax Attention, сочетая эффективность первого с точностью второго.

Каждый 8-слойный блок включает 7 слоев Lightning Attention и 1 слой SoftMax Attention, обеспечивая оптимальную производительность в различных задачах.

Обучение и оптимизация

Minimax использует передовые методы, такие как Varlen Ring Attention и LASP+, для оптимизации обработки длинных последовательностей и сокращения вычислительных отходов.

Архитектура MoE дополнительно оптимизирована с помощью стратегий группировки токенов и перекрытия EP-ETP, минимизируя накладные расходы на связь и максимизируя использование ресурсов.

Тесты производительности

Обработка длинного контекста

В тесте Ruler, MiniMax-Text-01 поддерживает высокую производительность (0,910-0,963) на длинах контекста от 4k до 1M токенов, значительно опережая модели, такие как Gemini-2.0-Flash.

Он достигает 100% точности в задаче поиска Needle-In-A-Haystack на 4M токенов, что подтверждает его возможности обработки длинного контекста.

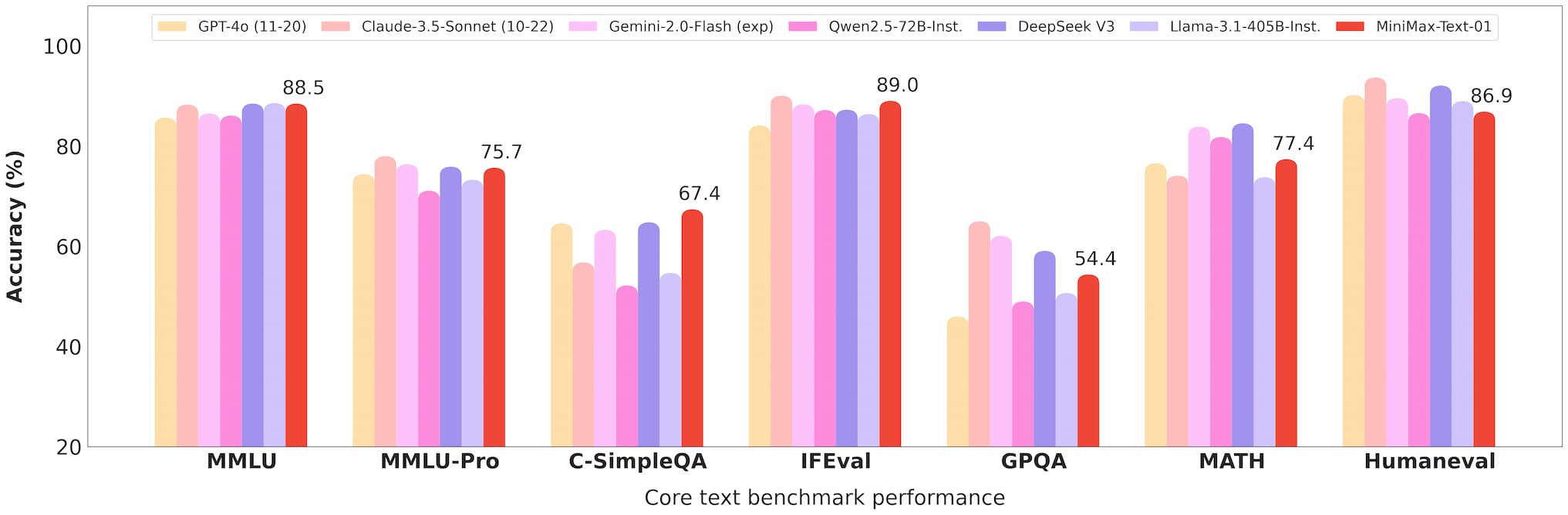

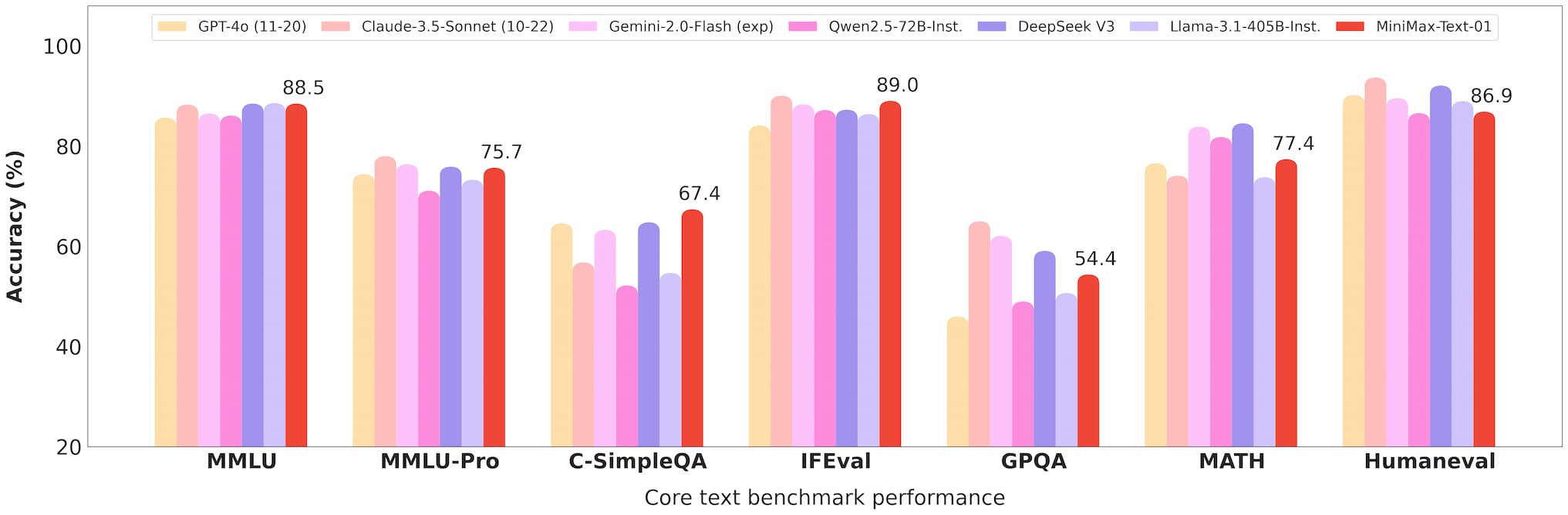

Текстовый тест Minimax 01

Мультимодальное понимание

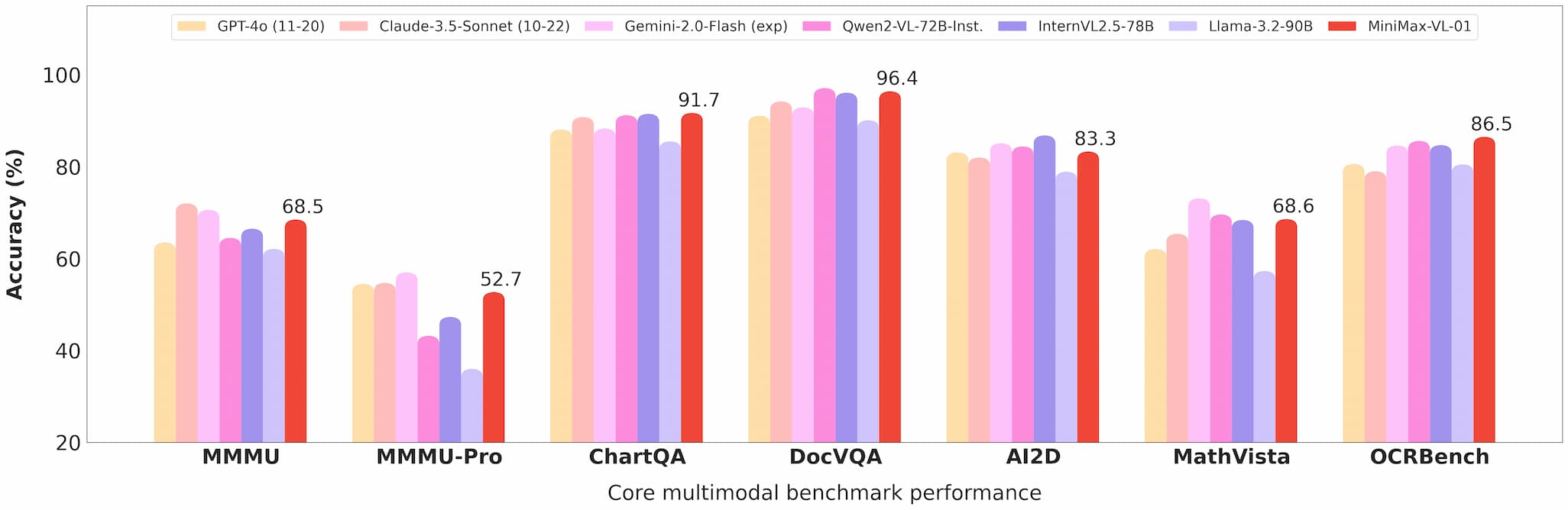

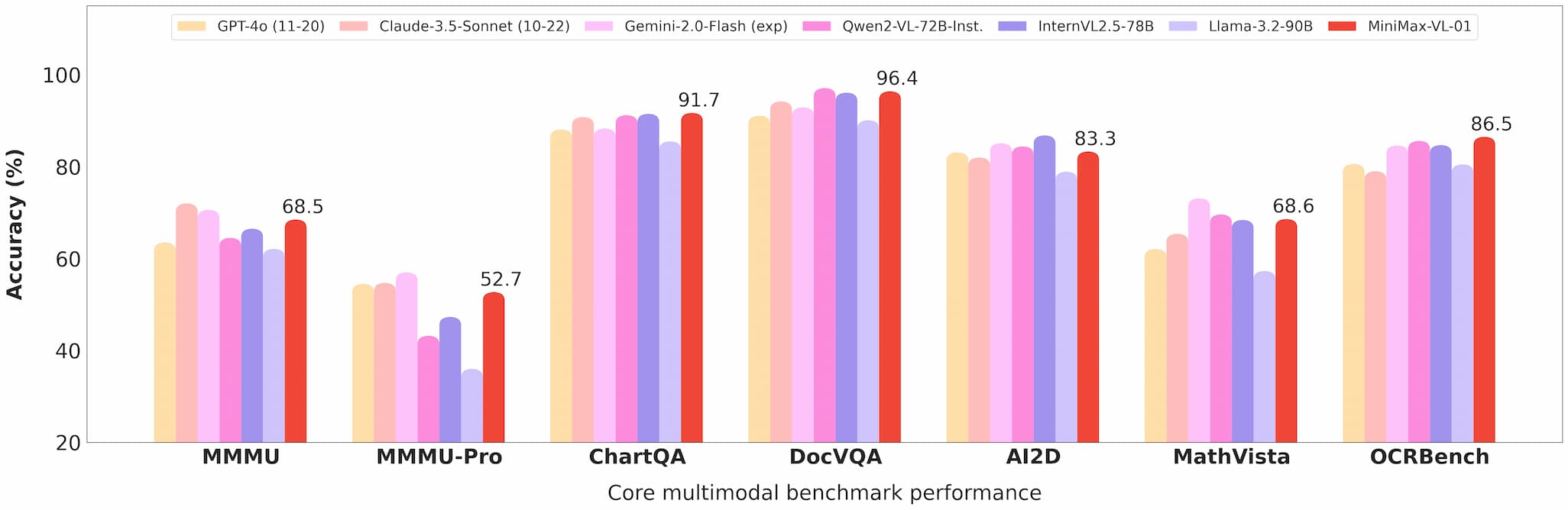

MiniMax-VL-01 преуспевает в задачах, таких как визуальный ответ на вопросы (VQA) и описание изображений, демонстрируя сильные результаты в академических и реальных тестах.

Тест зрения Minimax 01

Эффективность затрат

С ценами API в $0,2 за миллион входных токенов и $1,6 за миллион выходных токенов, Minimax предлагает непревзойденную ценность для разработчиков.

Коммерциализация и открытый исходный код

Доступ к API

Модели доступны через платформу Minimax Open Platform с конкурентоспособными ценами и регулярными обновлениями.

Разработчики могут легко интегрировать эти модели в свои приложения благодаря подробной документации и поддержке.

Открытый исходный код

Minimax открыла исходный код полных весов обеих моделей на GitHub и Hugging Face, поощряя вклад сообщества и дальнейшие исследования.

Приложения

ИИ-агенты

Возможность обработки длинных контекстов делает эти модели идеальными для создания систем постоянной памяти и фреймворков многопользовательской коммуникации.

Мультимодальные задачи

От медицинской визуализации до автономного вождения, возможности MiniMax-VL-01 открывают новые возможности для отраслей, требующих продвинутого визуально-языкового понимания.

Экономичные решения

Низкая стоимость API делает эти модели доступными для стартапов и малых предприятий, демократизируя доступ к передовым технологиям ИИ.

Отзывы пользователей и реальные тесты

Ранние пользователи высоко оценили серию MiniMax-01 за ее производительность и универсальность:

- Разработчики сообщили о плавной интеграции и значительных улучшениях в задачах, таких как резюмирование документов и генерация мультимодального контента.

- Исследователи ценят открытый характер моделей, позволяющий настройку и эксперименты.

Перспективы на будущее

Minimax предвидит будущее, где ИИ-агенты и мультимодальные системы станут повсеместными. Серия MiniMax-01 — это шаг в этом направлении, предлагая инструменты, необходимые для создания сложных приложений ИИ с длинным контекстом.

Заключение

Серия MiniMax-01 — это больше, чем просто технологическое достижение; это катализатор инноваций в сообществе ИИ. С ее непревзойденной обработкой длинного контекста, мультимодальными возможностями и экономической эффективностью, эта серия переопределяет то, что возможно в разработке ИИ.

Для разработчиков, стремящихся оставаться на передовой, серия MiniMax-01 — это обязательное исследование. Посетите платформу Minimax Open Platform или проверьте репозиторий на GitHub, чтобы начать сегодня.

Ссылки

Для разработчиков, желающих глубже изучить серию MiniMax-01, следующие ресурсы бесценны: