Minimax 01: Ontgrendeling van 4M token lange-context verwerking voor AI-ontwikkelaars

Maandag 15 januari 2025 Door Ethan Chueng

Inleiding

Het AI-landschap evolueert in een ongekend tempo, en MiniMax, een toonaangevend AI-bedrijf, heeft opnieuw de grenzen verlegd met zijn nieuwste release — de MiniMax-01-serie. Deze baanbrekende serie omvat twee modellen: MiniMax-Text-01, een fundamenteel taalmodel, en MiniMax-VL-01, een visueel-taalkundig multimodaal model. Deze modellen zijn ontworpen om ultra-lange contexten en complexe multimodale taken te verwerken, waardoor nieuwe normen worden gesteld voor AI-mogelijkheden.

De MiniMax-01-serie is niet zomaar een incrementele verbetering; het vertegenwoordigt een paradigmaverschuiving in hoe AI-modellen informatie verwerken. Met innovaties zoals Lightning Attention en Mixture of Experts (MoE) heeft Minimax bereikt wat velen voor onmogelijk hielden: efficiënte verwerking van contexten tot 4 miljoen tokens, ver voorbij de mogelijkheden van toonaangevende modellen zoals GPT-4o en Claude-3.5-Sonnet.

Deze blog is afgestemd op AI-ontwikkelaars en biedt een diepgaande blik op de technische innovaties, prestatiebenchmarks en praktische toepassingen van de MiniMax-01-serie. Of je nu AI-agenten bouwt, multimodale applicaties ontwikkelt of lange-context verwerking verkent, deze serie is een tool die je niet kunt negeren.

Minimax 01 model

Modeloverzicht

De MiniMax-01-serie is een bewijs van MiniMax's toewijding aan innovatie. Hier is een snel overzicht van de twee modellen:

1. MiniMax-Text-01: Een taalmodel geoptimaliseerd voor ultra-lange context verwerking, in staat om tot 4 miljoen tokens te verwerken tijdens inferentie.

2. MiniMax-VL-01: Een multimodaal model dat visueel en taalkundig begrip combineert, getraind op 512 miljard visueel-taalkundige tokens.

Kerninnovaties:

- Lightning Attention: Een nieuw mechanisme dat de rekencomplexiteit van aandacht reduceert van kwadratisch naar lineair, waardoor efficiënte verwerking van lange sequenties mogelijk wordt.

- Mixture of Experts (MoE): Een hybride architectuur met 456 miljard parameters, waarvan 45,9 miljard per token worden geactiveerd, wat zorgt voor hoge efficiëntie en schaalbaarheid.

Technische diepgaande duik

Lightning Attention

Traditionele Transformer-modellen worstelen met lange sequenties vanwege hun kwadratische complexiteit. MiniMax's Lightning Attention lost dit op door de aandachtberekening te verdelen in intra-block en inter-block operaties, terwijl lineaire complexiteit behouden blijft.

Deze innovatie stelt het model in staat om 4 miljoen tokens efficiënt te verwerken, een prestatie die ongeëvenaard is door concurrenten.

Hybride architectuur

Het model wisselt af tussen Lightning Attention en traditionele SoftMax Attention-lagen, waarbij de efficiëntie van de eerste wordt gecombineerd met de precisie van de laatste.

Elke 8-laags blok bevat 7 Lightning Attention-lagen en 1 SoftMax Attention-laag, wat zorgt voor optimale prestaties over verschillende taken.

Training en optimalisatie

Minimax gebruikt geavanceerde technieken zoals Varlen Ring Attention en LASP+ om lange-sequentie verwerking te optimaliseren en rekenverspilling te verminderen.

De MoE-architectuur wordt verder geoptimaliseerd met token-groepering en EP-ETP-overlapping strategieën, waardoor communicatie-overhead wordt geminimaliseerd en resource-gebruik wordt gemaximaliseerd.

Prestatiebenchmarks

Lange-context verwerking

In de Ruler-benchmark behoudt MiniMax-Text-01 een hoge prestatie (0.910-0.963) over contextlengtes van 4k tot 1M tokens, waarbij het modellen zoals Gemini-2.0-Flash significant overtreft.

Het bereikt 100% nauwkeurigheid in de 4M-token Needle-In-A-Haystack-retrievaltaak, een bewijs van zijn lange-context mogelijkheden.

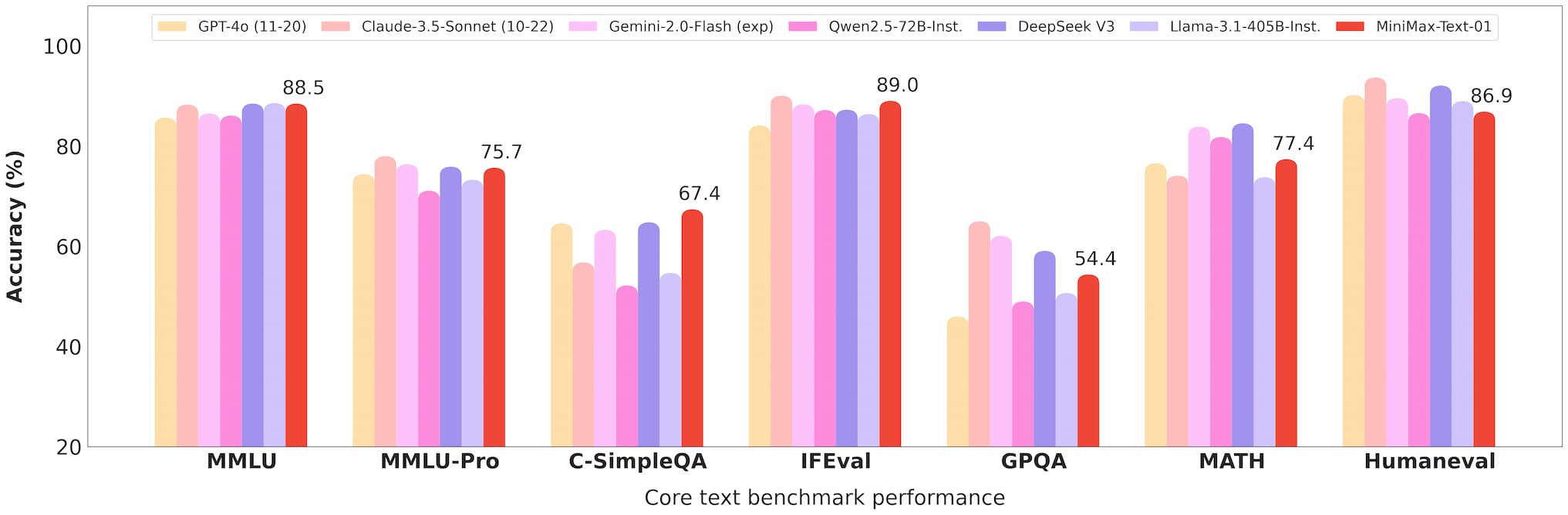

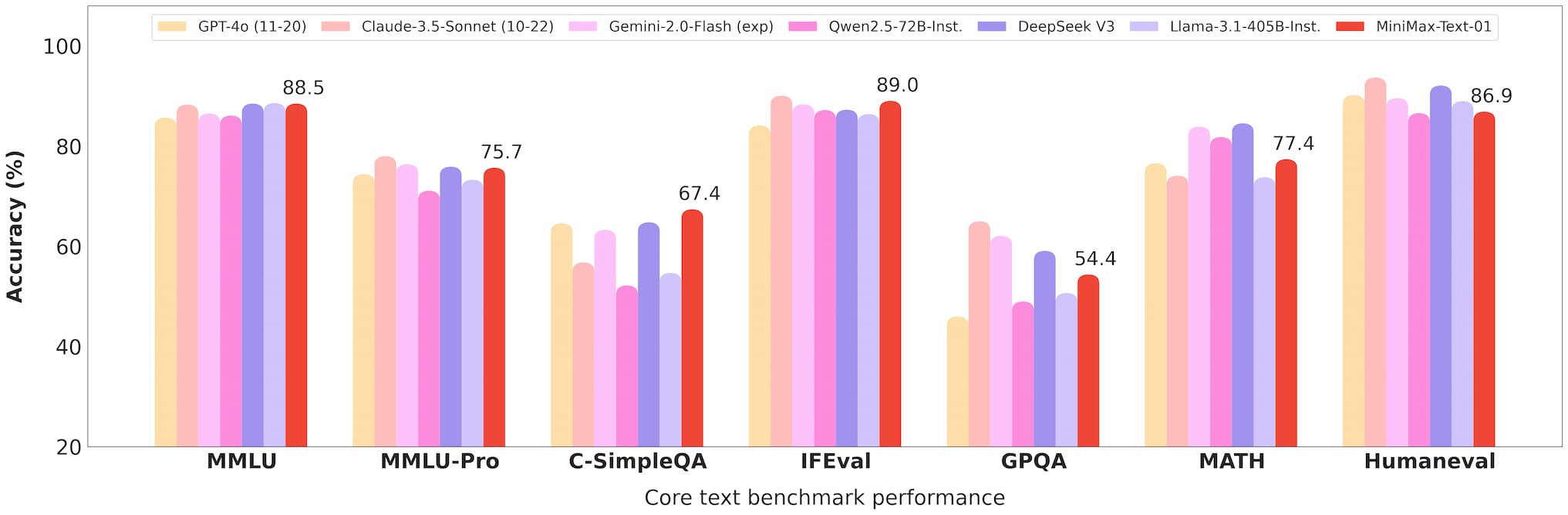

Minimax 01 tekst benchmark

Multimodaal begrip

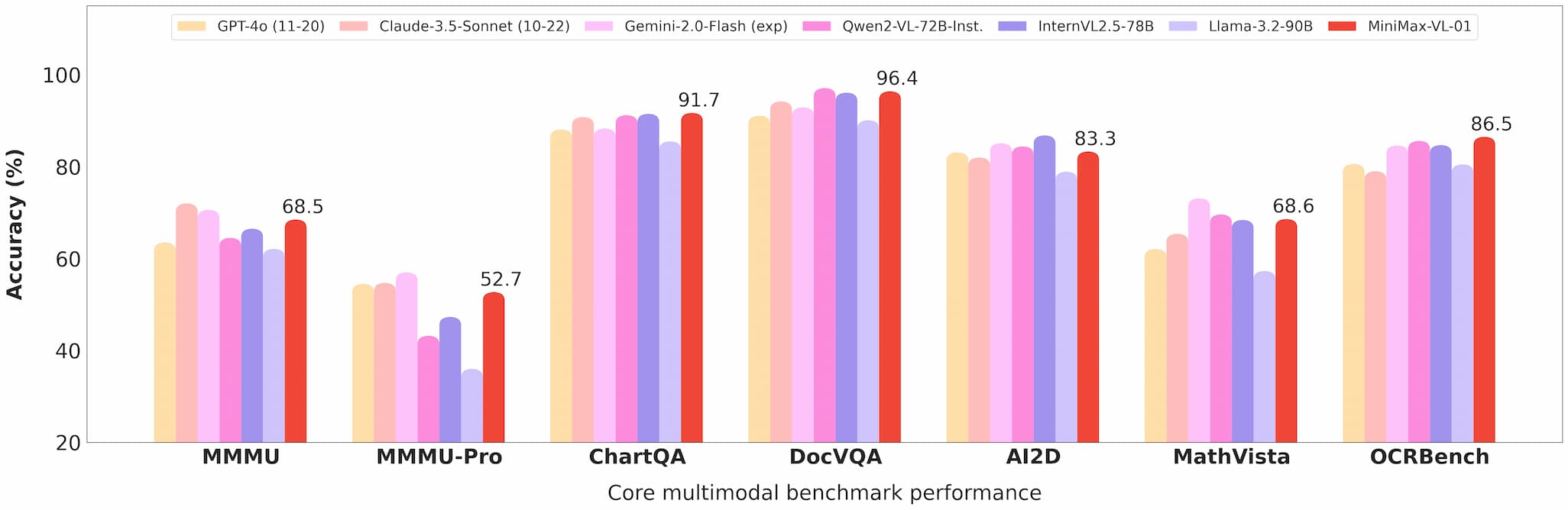

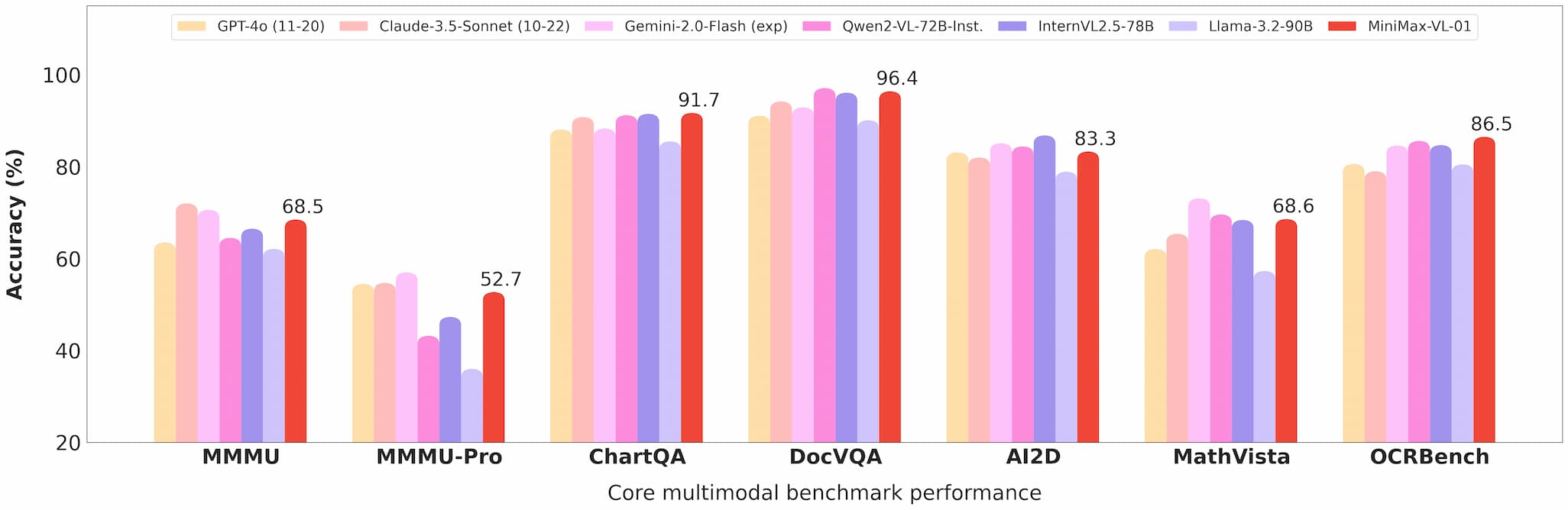

MiniMax-VL-01 blinkt uit in taken zoals visuele vraagbeantwoording (VQA) en beeldbeschrijving, en toont sterke prestaties in academische en real-world benchmarks.

Minimax 01 visie benchmark

Kostenefficiëntie

Met API-prijzen van $0.2 per miljoen invoer-tokens en $1.6 per miljoen uitvoer-tokens, biedt Minimax een ongeëvenaarde waarde voor ontwikkelaars.

Commercialisering en open source

API-toegang

De modellen zijn beschikbaar via het Minimax Open Platform, met concurrerende prijzen en regelmatige updates.

Ontwikkelaars kunnen deze modellen eenvoudig integreren in hun applicaties, dankzij uitgebreide documentatie en ondersteuning.

Open source

Minimax heeft de volledige gewichten van beide modellen open source gemaakt op GitHub en Hugging Face, wat bijdraagt aan gemeenschapsbijdragen en verder onderzoek.

Toepassingen

AI-agenten

De mogelijkheid om lange contexten te verwerken maakt deze modellen ideaal voor het bouwen van persistente geheugensystemen en multi-agent communicatieframeworks.

Multimodale taken

Van medische beeldvorming tot autonoom rijden, de mogelijkheden van MiniMax-VL-01 openen nieuwe mogelijkheden voor industrieën die geavanceerd visueel-taalkundig begrip vereisen.

Kosteneffectieve oplossingen

De low-cost API maakt deze modellen toegankelijk voor startups en kleine bedrijven, waardoor toegang tot geavanceerde AI-technologie wordt gedemocratiseerd.

Gebruikersfeedback en real-world tests

Vroege gebruikers hebben de MiniMax-01-serie geprezen om zijn prestaties en veelzijdigheid:

- Ontwikkelaars hebben naadloze integratie en significante verbeteringen gerapporteerd in taken zoals documentensamenvatting en multimodale inhoudsgeneratie.

- Onderzoekers waarderen de open-source aard van de modellen, wat aanpassing en experimenteren mogelijk maakt.

Toekomstperspectieven

Minimax voorziet een toekomst waarin AI-agenten en multimodale systemen alomtegenwoordig zijn. De MiniMax-01-serie is een stap in die richting, en biedt de tools die nodig zijn om complexe, lange-context AI-applicaties te bouwen.

Conclusie

De MiniMax-01-serie is meer dan alleen een technologische prestatie; het is een katalysator voor innovatie in de AI-gemeenschap. Met zijn ongeëvenaarde lange-context verwerking, multimodale mogelijkheden en kostenefficiëntie, is deze serie bezig met het herdefiniëren van wat mogelijk is in AI-ontwikkeling.

Voor ontwikkelaars die voorop willen blijven, is de MiniMax-01-serie een must-explore. Bezoek het Minimax Open Platform of bekijk de GitHub-repository om vandaag nog te beginnen.

Referenties

Voor ontwikkelaars die dieper willen duiken in de MiniMax-01-serie, zijn de volgende bronnen onmisbaar: