Minimax 01: AI 개발자를 위한 4M 토큰 장문 컨텍스트 처리의 해방

2025년 1월 15일 월요일 Ethan Chueng 저

소개

AI 환경은 전례 없는 속도로 진화하고 있으며, AI 분야의 선두주자인 MiniMax는 최신 출시작인 MiniMax-01 시리즈로 다시 한계를 넓혔습니다. 이 획기적인 시리즈에는 기본 언어 모델인 MiniMax-Text-01과 시각 및 언어를 결합한 멀티모달 모델인 MiniMax-VL-01 두 가지 모델이 포함되어 있습니다. 이 모델들은 초장문 컨텍스트와 복잡한 멀티모달 작업을 처리하도록 설계되어 AI의 능력에 새로운 기준을 세웠습니다.

MiniMax-01 시리즈는 단순한 점진적인 개선이 아닙니다. AI 모델이 정보를 처리하는 방식의 패러다임 전환을 나타냅니다. Lightning Attention 및 Mixture of Experts (MoE)와 같은 혁신을 통해 MiniMax는 많은 사람들이 불가능하다고 생각했던 것을 달성했습니다: 최대 400만 토큰의 컨텍스트를 효율적으로 처리하는 것입니다. 이는 GPT-4o 및 Claude-3.5-Sonnet과 같은 주요 모델의 능력을 훨씬 뛰어넘습니다.

이 블로그는 AI 개발자를 위해 설계되었으며, MiniMax-01 시리즈의 기술 혁신, 성능 벤치마크 및 실제 응용 프로그램에 대해 깊이 있게 탐구합니다. AI 에이전트 구축, 멀티모달 애플리케이션 개발, 장문 컨텍스트 처리 탐구 등, 이 시리즈는 무시할 수 없는 도구입니다.

Minimax 01 모델

모델 개요

MiniMax-01 시리즈는 MiniMax의 혁신에 대한 약속을 증명합니다. 다음은 두 모델의 간단한 개요입니다:

1. MiniMax-Text-01: 초장문 컨텍스트 처리에 최적화된 언어 모델로, 추론 중 최대 400만 토큰을 처리할 수 있습니다.

2. MiniMax-VL-01: 시각 및 언어 이해를 결합한 멀티모달 모델로, 5120억 개의 시각 언어 토큰으로 훈련되었습니다.

핵심 혁신:

- Lightning Attention: 주의 계산의 복잡도를 2차에서 선형으로 줄이는 새로운 메커니즘으로, 긴 시퀀스의 효율적인 처리를 가능하게 합니다.

- Mixture of Experts (MoE): 4560억 개의 매개변수를 가진 하이브리드 아키텍처로, 토큰당 459억 개가 활성화되어 높은 효율성과 확장성을 보장합니다.

기술적 심층 분석

Lightning Attention

기존의 Transformer 모델은 2차적인 복잡성으로 인해 긴 시퀀스에 어려움을 겪습니다. MiniMax의 Lightning Attention은 주의 계산을 블록 내 작업과 블록 간 작업으로 나누어 선형 복잡성을 유지함으로써 이 문제를 해결합니다.

이 혁신은 모델이 400만 토큰을 효율적으로 처리할 수 있게 하며, 경쟁사와는 비교할 수 없는 성과를 달성합니다.

하이브리드 아키텍처

모델은 Lightning Attention과 기존의 SoftMax Attention 레이어를 번갈아 사용하며, 전자의 효율성과 후자의 정확성을 결합합니다.

8개 레이어의 각 블록에는 7개의 Lightning Attention 레이어와 1개의 SoftMax Attention 레이어가 포함되어 있어 다양한 작업에서 최적의 성능을 보장합니다.

훈련 및 최적화

MiniMax는 Varlen Ring Attention 및 LASP+와 같은 고급 기술을 사용하여 긴 시퀀스 처리를 최적화하고 계산 낭비를 줄입니다.

MoE 아키텍처는 토큰 그룹화 및 EP-ETP 중첩 전략으로 더욱 최적화되어 통신 오버헤드를 최소화하고 리소스 활용을 극대화합니다.

성능 벤치마크

장문 컨텍스트 처리

Ruler 벤치마크에서 MiniMax-Text-01은 4k에서 1M 토큰의 컨텍스트 길이에서 높은 성능(0.910-0.963)을 유지하며, Gemini-2.0-Flash와 같은 모델을 크게 능가합니다.

4M 토큰의 Needle-In-A-Haystack 검색 작업에서 100% 정확도를 달성하여 장문 컨텍스트 능력을 입증했습니다.

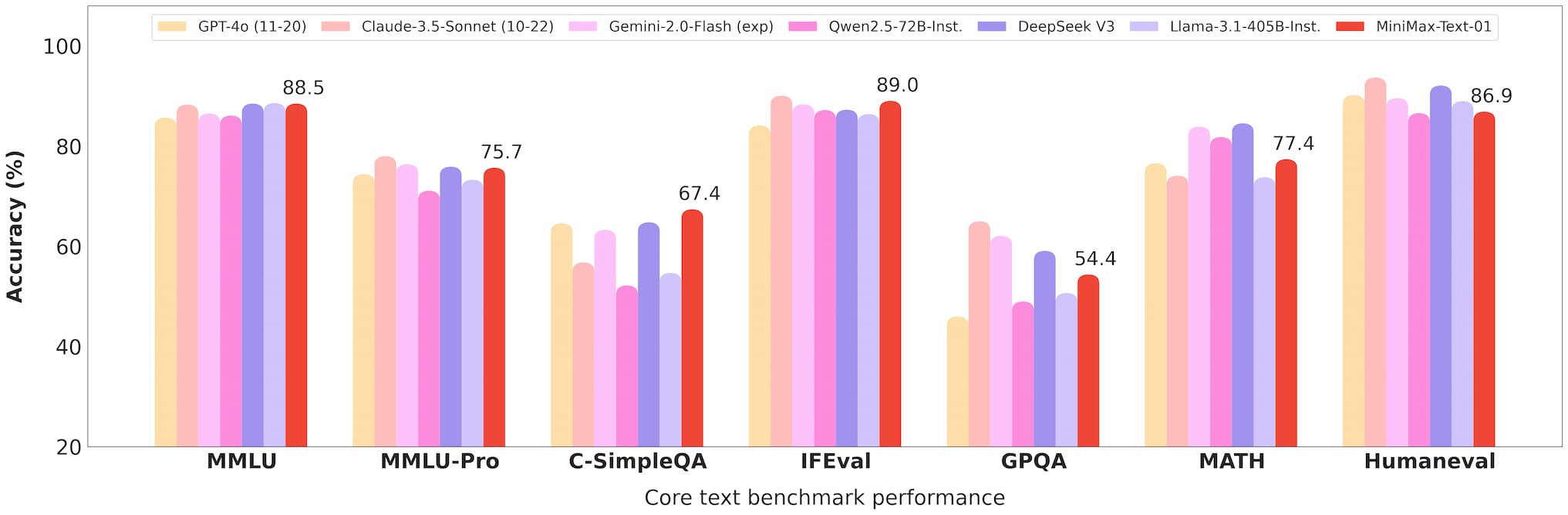

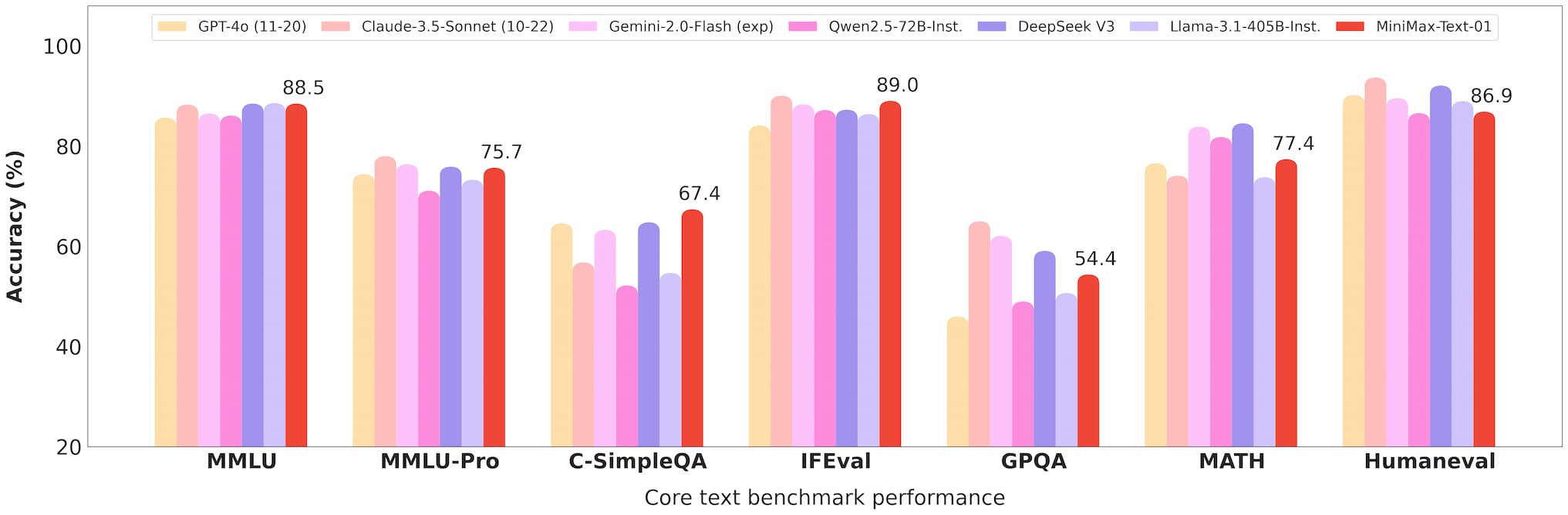

Minimax 01 텍스트 벤치마크

멀티모달 이해

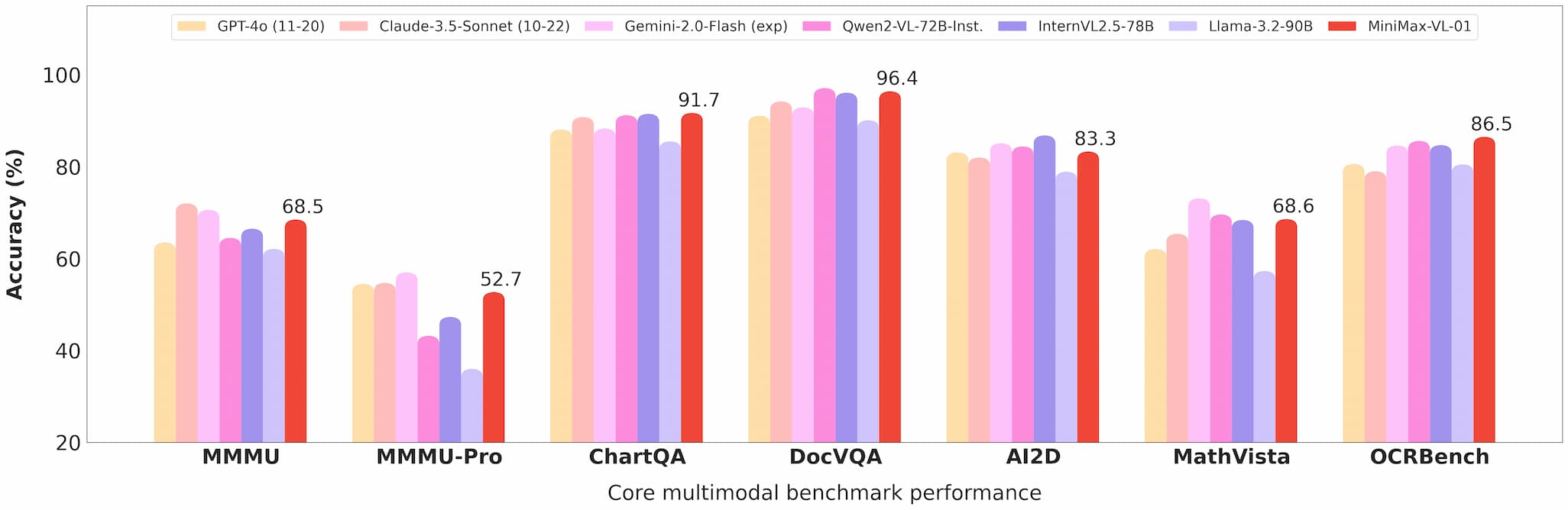

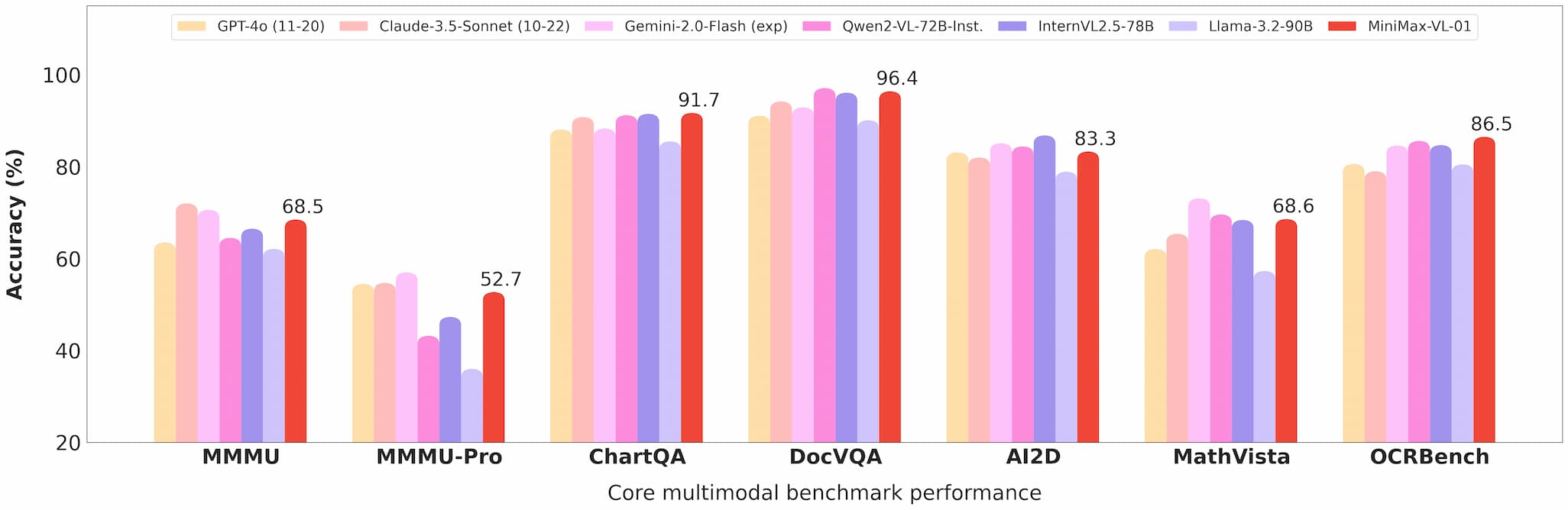

MiniMax-VL-01은 시각적 질문 응답(VQA) 및 이미지 캡션 작업에서 뛰어나며, 학술적 및 실제 세계 벤치마크에서 강력한 성능을 보여줍니다.

Minimax 01 비전 벤치마크

비용 효율성

API 가격은 입력 100만 토큰당 $0.2, 출력 100만 토큰당 $1.6으로, MiniMax는 개발자에게 비교할 수 없는 가치를 제공합니다.

상용화 및 오픈 소스

API 접근

모델은 Minimax Open Platform을 통해 이용 가능하며, 경쟁력 있는 가격과 정기적인 업데이트가 제공됩니다.

개발자는 포괄적인 문서와 지원 덕분에 이러한 모델을 애플리케이션에 쉽게 통합할 수 있습니다.

오픈 소스

MiniMax는 GitHub와 Hugging Face에서 두 모델의 완전한 가중치를 오픈 소스로 공개하여 커뮤니티 기여와 추가 연구를 장려하고 있습니다.

응용 프로그램

AI 에이전트

장문 컨텍스트를 처리하는 능력은 이러한 모델을 영구 메모리 시스템 및 다중 에이전트 통신 프레임워크 구축에 이상적으로 만듭니다.

멀티모달 작업

의료 영상에서 자율 주행까지, MiniMax-VL-01의 능력은 고급 시각 언어 이해가 필요한 산업에 새로운 가능성을 열어줍니다.

비용 효율적인 솔루션

저렴한 API는 이러한 모델을 스타트업 및 중소기업이 접근할 수 있게 하여 최첨단 AI 기술에 대한 접근을 민주화합니다.

사용자 피드백 및 실제 테스트

초기 사용자들은 MiniMax-01 시리즈의 성능과 다용도성을 칭찬했습니다:

- 개발자들은 문서 요약 및 멀티모달 콘텐츠 생성과 같은 작업에서 원활한 통합과 상당한 개선을 보고했습니다.

- 연구자들은 모델의 오픈 소스 특성을 높이 평가하며, 이를 통해 사용자 정의와 실험이 가능하다고 말했습니다.

미래 전망

MiniMax는 AI 에이전트와 멀티모달 시스템이 보편화되는 미래를 상상합니다. MiniMax-01 시리즈는 이러한 비전을 향한 한 걸음으로, 복잡하고 장문 컨텍스트 AI 애플리케이션을 구축하는 데 필요한 도구를 제공합니다.

결론

MiniMax-01 시리즈는 단순한 기술적 성과 이상입니다. AI 커뮤니티에서 혁신의 촉매제입니다. 비교할 수 없는 장문 컨텍스트 처리, 멀티모달 능력 및 비용 효율성을 통해 이 시리즈는 AI 개발에서 가능한 것을 재정의하고 있습니다.

최첨단을 유지하려는 개발자에게 MiniMax-01 시리즈는 필수 탐구 대상입니다. Minimax Open Platform을 방문하거나 GitHub 저장소를 확인하여 오늘부터 시작하세요.

참고 자료

MiniMax-01 시리즈에 대해 더 깊이 알고 싶은 개발자에게 다음 자료는 귀중합니다: