Minimax 01: Sbloccare l'elaborazione di contesti lunghi di 4M token per gli sviluppatori di IA

Lunedì 15 gennaio 2025 Di Ethan Chueng

Introduzione

Il panorama dell'IA sta evolvendo a un ritmo senza precedenti, e MiniMax, una società leader nel campo dell'IA, ha nuovamente spinto i limiti con il suo ultimo lancio — la serie MiniMax-01. Questa serie rivoluzionaria include due modelli: MiniMax-Text-01, un modello linguistico di base, e MiniMax-VL-01, un modello multimodale visivo-linguistico. Questi modelli sono progettati per gestire contesti ultra-lunghi e compiti multimodali complessi, stabilendo nuovi standard per le capacità dell'IA.

La serie MiniMax-01 non è solo un altro miglioramento incrementale; rappresenta un cambiamento di paradigma nel modo in cui i modelli di IA elaborano le informazioni. Con innovazioni come Lightning Attention e Mixture of Experts (MoE), Minimax ha raggiunto ciò che molti pensavano impossibile: l'elaborazione efficiente di contesti fino a 4 milioni di token, superando di gran lunga le capacità di modelli leader come GPT-4o e Claude-3.5-Sonnet.

Questo blog è pensato per gli sviluppatori di IA, offrendo un'immersione profonda nelle innovazioni tecniche, nei benchmark delle prestazioni e nelle applicazioni pratiche della serie MiniMax-01. Che tu stia costruendo agenti di IA, sviluppando applicazioni multimodali o esplorando l'elaborazione di contesti lunghi, questa serie è uno strumento che non puoi ignorare.

Modello Minimax 01

Panoramica del modello

La serie MiniMax-01 è una testimonianza dell'impegno di Minimax verso l'innovazione. Ecco una rapida panoramica dei due modelli:

1. MiniMax-Text-01: Un modello linguistico ottimizzato per l'elaborazione di contesti ultra-lunghi, in grado di gestire fino a 4 milioni di token durante l'inferenza.

2. MiniMax-VL-01: Un modello multimodale che combina comprensione visiva e linguistica, addestrato su 512 miliardi di token visivo-linguistici.

Innovazioni chiave:

- Lightning Attention: Un meccanismo innovativo che riduce la complessità computazionale dell'attenzione da quadratica a lineare, consentendo un'elaborazione efficiente di sequenze lunghe.

- Mixture of Experts (MoE): Un'architettura ibrida con 456 miliardi di parametri, di cui 45,9 miliardi vengono attivati per token, garantendo alta efficienza e scalabilità.

Approfondimento tecnico

Lightning Attention

I modelli Transformer tradizionali faticano con sequenze lunghe a causa della loro complessità quadratica. Il Lightning Attention di Minimax risolve questo problema dividendo il calcolo dell'attenzione in operazioni intra-blocco e inter-blocco, mantenendo una complessità lineare.

Questa innovazione consente al modello di elaborare 4 milioni di token in modo efficiente, un risultato senza pari tra i concorrenti.

Architettura ibrida

Il modello alterna tra strati di Lightning Attention e strati di attenzione SoftMax tradizionali, combinando l'efficienza del primo con la precisione del secondo.

Ogni blocco di 8 strati include 7 strati di Lightning Attention e 1 strato di attenzione SoftMax, garantendo prestazioni ottimali su vari compiti.

Addestramento e ottimizzazione

Minimax utilizza tecniche avanzate come Varlen Ring Attention e LASP+ per ottimizzare l'elaborazione di sequenze lunghe e ridurre gli sprechi computazionali.

L'architettura MoE è ulteriormente ottimizzata con strategie di raggruppamento di token e sovrapposizione EP-ETP, minimizzando il sovraccarico di comunicazione e massimizzando l'utilizzo delle risorse.

Benchmark delle prestazioni

Elaborazione di contesti lunghi

Nel benchmark Ruler, MiniMax-Text-01 mantiene prestazioni elevate (0,910-0,963) su lunghezze di contesto da 4k a 1M token, superando significativamente modelli come Gemini-2.0-Flash.

Raggiunge il 100% di precisione nel compito di recupero Needle-In-A-Haystack da 4M token, una prova delle sue capacità di contesto lungo.

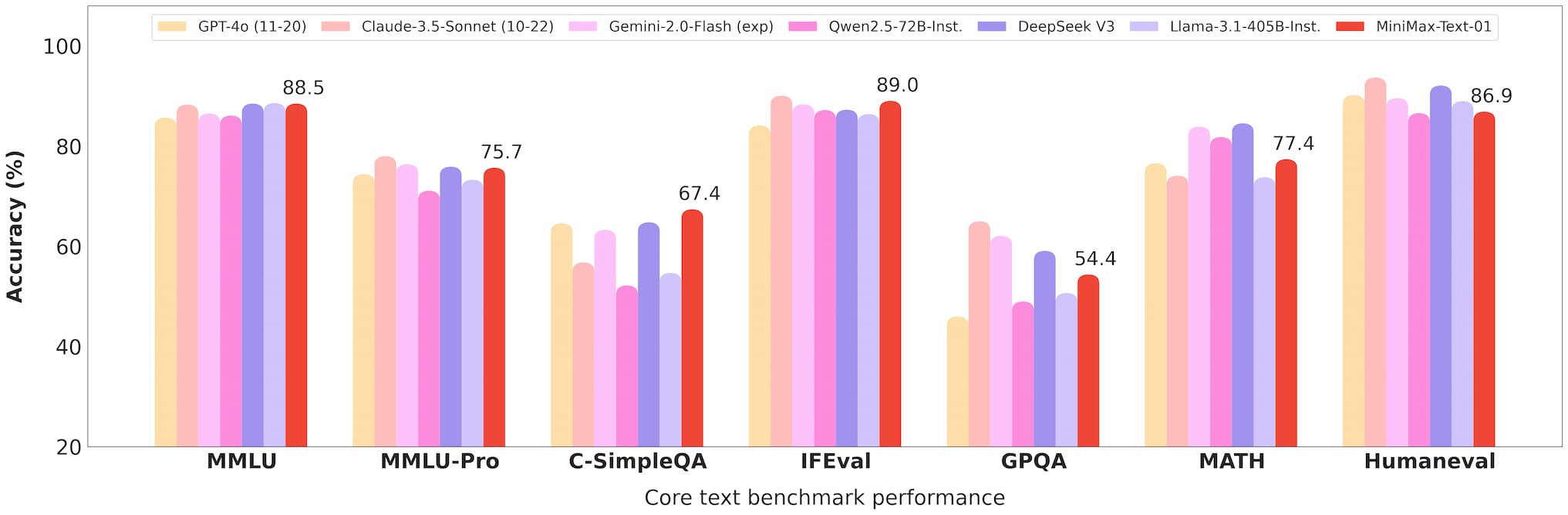

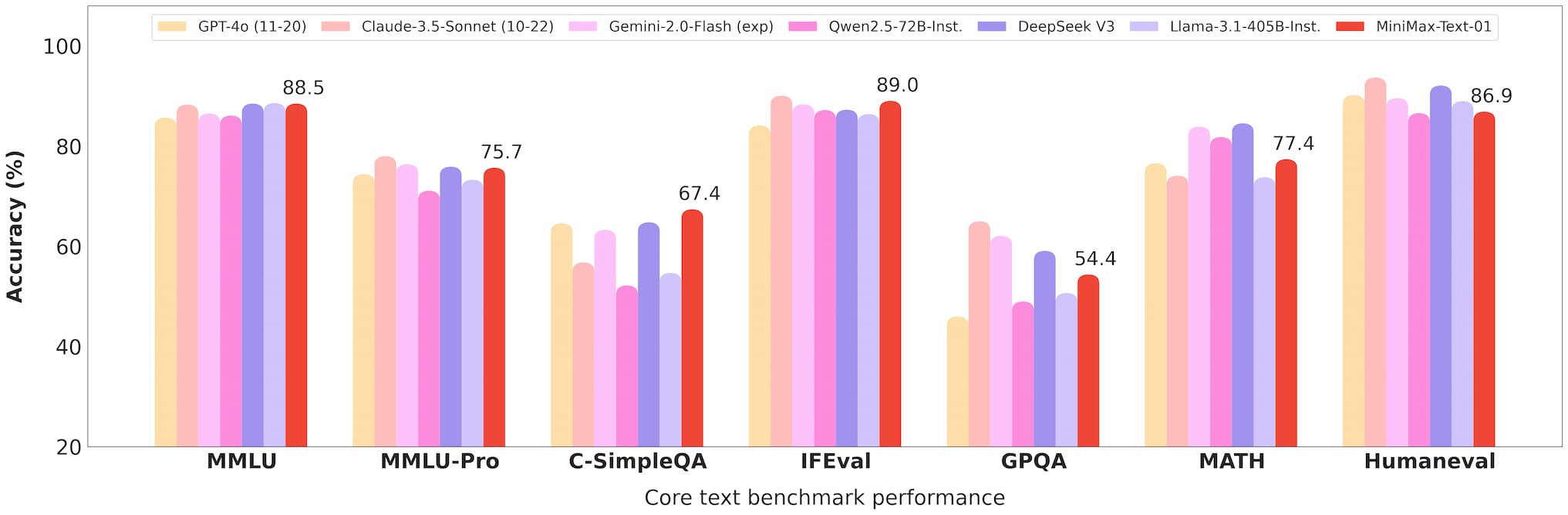

Benchmark testo Minimax 01

Comprensione multimodale

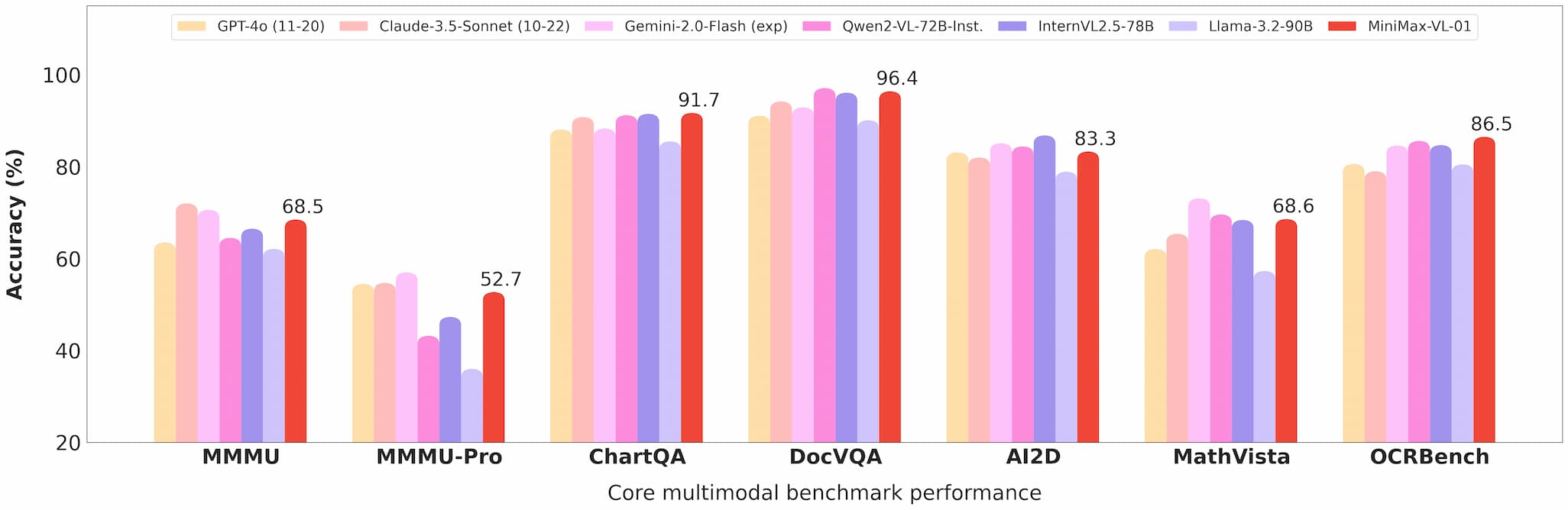

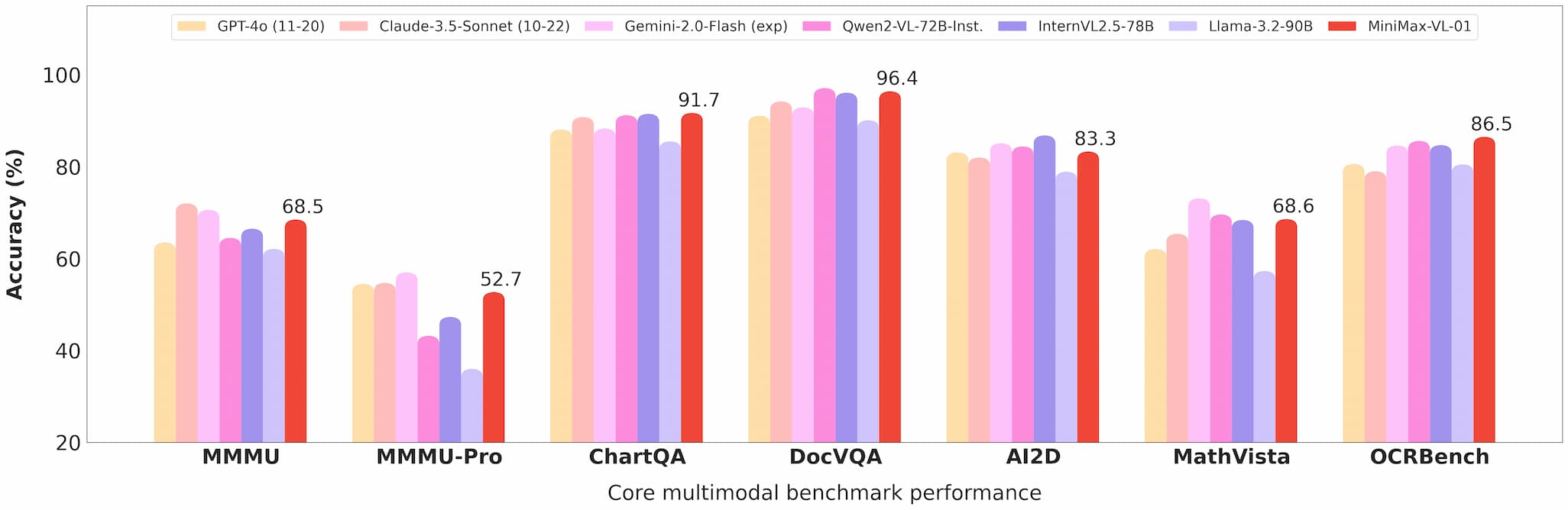

MiniMax-VL-01 eccelle in compiti come risposta visiva a domande (VQA) e descrizione di immagini, dimostrando prestazioni solide in benchmark accademici e reali.

Benchmark visione Minimax 01

Efficienza dei costi

Con prezzi API di $0,2 per milione di token di input e $1,6 per milione di token di output, Minimax offre un valore senza pari per gli sviluppatori.

Commercializzazione e open source

Accesso API

I modelli sono disponibili tramite la piattaforma Minimax Open Platform, con prezzi competitivi e aggiornamenti regolari.

Gli sviluppatori possono integrare questi modelli nelle loro applicazioni con facilità, grazie a una documentazione completa e al supporto.

Open source

Minimax ha reso open source i pesi completi di entrambi i modelli su GitHub e Hugging Face, incoraggiando i contributi della comunità e ulteriori ricerche.

Applicazioni

Agenti di IA

La capacità di gestire contesti lunghi rende questi modelli ideali per costruire sistemi di memoria persistente e framework di comunicazione multi-agente.

Compiti multimodali

Dall'imaging medico alla guida autonoma, le capacità di MiniMax-VL-01 aprono nuove possibilità per le industrie che richiedono una comprensione avanzata del linguaggio visivo.

Soluzioni convenienti

L'API a basso costo rende questi modelli accessibili a startup e piccole imprese, democratizzando l'accesso alla tecnologia AI all'avanguardia.

Feedback degli utenti e test nel mondo reale

I primi utenti hanno elogiato la serie MiniMax-01 per le sue prestazioni e versatilità:

- Gli sviluppatori hanno riportato un'integrazione senza soluzione di continuità e miglioramenti significativi in compiti come il riassunto di documenti e la generazione di contenuti multimodali.

- I ricercatori apprezzano la natura open source dei modelli, che consente personalizzazione e sperimentazione.

Prospettive future

Minimax prevede un futuro in cui gli agenti di IA e i sistemi multimodali saranno onnipresenti. La serie MiniMax-01 è un passo verso questa visione, offrendo gli strumenti necessari per costruire applicazioni AI complesse e a contesto lungo.

Conclusione

La serie MiniMax-01 è più di un risultato tecnologico; è un catalizzatore per l'innovazione nella comunità AI. Con la sua elaborazione di contesti lunghi senza precedenti, capacità multimodali ed efficienza dei costi, questa serie sta ridefinendo ciò che è possibile nello sviluppo dell'IA.

Per gli sviluppatori che desiderano rimanere all'avanguardia, la serie MiniMax-01 è una esplorazione obbligata. Visita la piattaforma Minimax Open Platform o controlla il repository GitHub per iniziare oggi.

Riferimenti

Per gli sviluppatori che desiderano approfondire la serie MiniMax-01, le seguenti risorse sono preziose: