Minimax 01 : Débloquer le traitement de contexte long de 4M tokens pour les développeurs d'IA

Lundi 15 janvier 2025 Par Ethan Chueng

Introduction

Le paysage de l'IA évolue à un rythme sans précédent, et MiniMax, une entreprise leader en IA, a une fois de plus repoussé les limites avec sa dernière sortie — la série MiniMax-01. Cette série révolutionnaire comprend deux modèles : MiniMax-Text-01, un modèle de langage fondamental, et MiniMax-VL-01, un modèle multimodal visuel-langage. Ces modèles sont conçus pour gérer des contextes ultra-longs et des tâches multimodales complexes, établissant de nouvelles normes pour les capacités de l'IA.

La série MiniMax-01 n'est pas simplement une amélioration incrémentale de plus ; elle représente un changement de paradigme dans la façon dont les modèles d'IA traitent l'information. Avec des innovations comme Lightning Attention et Mixture of Experts (MoE), Minimax a réalisé ce que beaucoup pensaient impossible : un traitement efficace de contextes allant jusqu'à 4 millions de tokens, surpassant largement les capacités des modèles leaders comme GPT-4o et Claude-3.5-Sonnet.

Ce blog est conçu pour les développeurs d'IA, offrant une plongée profonde dans les innovations techniques, les benchmarks de performance et les applications pratiques de la série MiniMax-01. Que vous construisiez des agents d'IA, développiez des applications multimodales ou exploriez le traitement de contexte long, cette série est un outil que vous ne pouvez pas ignorer.

Modèle Minimax 01

Aperçu du modèle

La série MiniMax-01 est un témoignage de l'engagement de Minimax envers l'innovation. Voici un aperçu rapide des deux modèles :

1. MiniMax-Text-01 : Un modèle de langage optimisé pour le traitement de contexte ultra-long, capable de gérer jusqu'à 4 millions de tokens lors de l'inférence.

2. MiniMax-VL-01 : Un modèle multimodal qui combine la compréhension visuelle et linguistique, entraîné sur 512 milliards de tokens visuels-langage.

Innovations clés :

- Lightning Attention : Un mécanisme novateur qui réduit la complexité computationnelle de l'attention de quadratique à linéaire, permettant un traitement efficace de longues séquences.

- Mixture of Experts (MoE) : Une architecture hybride avec 456 milliards de paramètres, dont 45,9 milliards sont activés par token, assurant une haute efficacité et une grande évolutivité.

Plongée technique approfondie

Lightning Attention

Les modèles Transformer traditionnels luttent avec les longues séquences en raison de leur complexité quadratique. Le Lightning Attention de Minimax résout ce problème en divisant le calcul de l'attention en opérations intra-bloc et inter-bloc, tout en maintenant une complexité linéaire.

Cette innovation permet au modèle de traiter efficacement 4 millions de tokens, une performance inégalée par la concurrence.

Architecture hybride

Le modèle alterne entre des couches de Lightning Attention et des couches d'attention SoftMax traditionnelles, combinant l'efficacité de la première avec la précision de la seconde.

Chaque bloc de 8 couches comprend 7 couches de Lightning Attention et 1 couche d'attention SoftMax, assurant des performances optimales sur diverses tâches.

Entraînement et optimisation

Minimax utilise des techniques avancées comme Varlen Ring Attention et LASP+ pour optimiser le traitement des longues séquences et réduire le gaspillage computationnel.

L'architecture MoE est encore optimisée avec des stratégies de regroupement de tokens et de chevauchement EP-ETP, minimisant la surcharge de communication et maximisant l'utilisation des ressources.

Benchmarks de performance

Traitement de contexte long

Dans le benchmark Ruler, MiniMax-Text-01 maintient une performance élevée (0,910-0,963) sur des longueurs de contexte allant de 4k à 1M tokens, surpassant significativement des modèles comme Gemini-2.0-Flash.

Il atteint une précision de 100% dans la tâche de récupération Needle-In-A-Haystack de 4M tokens, un témoignage de ses capacités de contexte long.

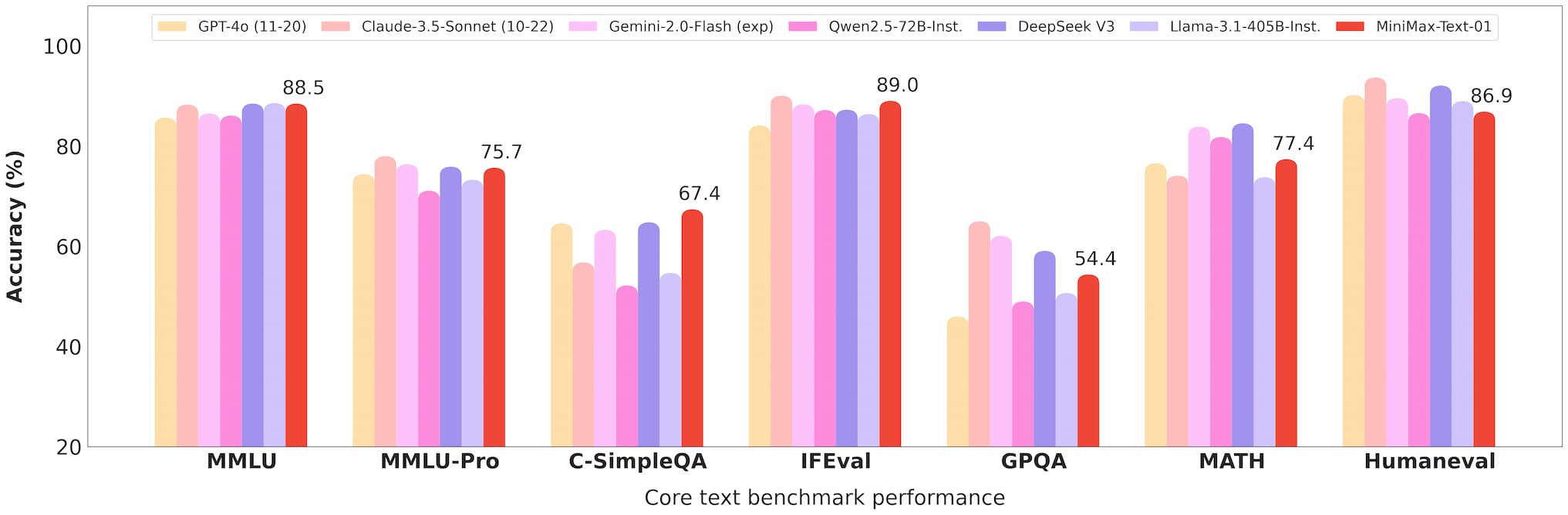

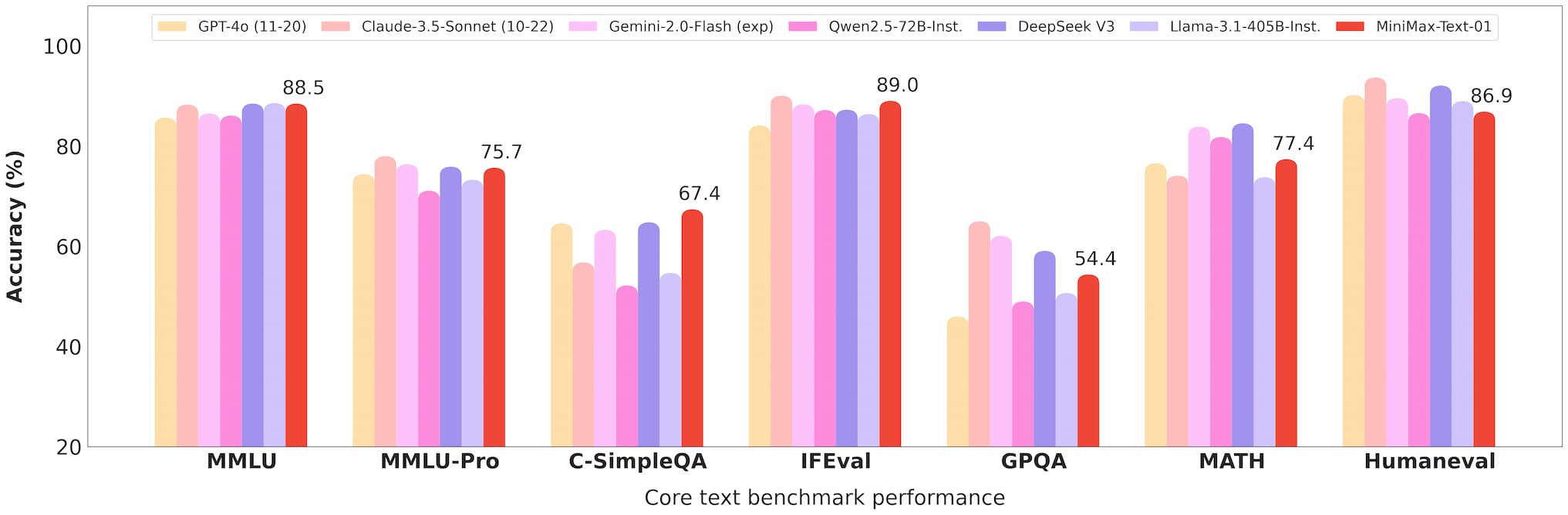

Benchmark texte Minimax 01

Compréhension multimodale

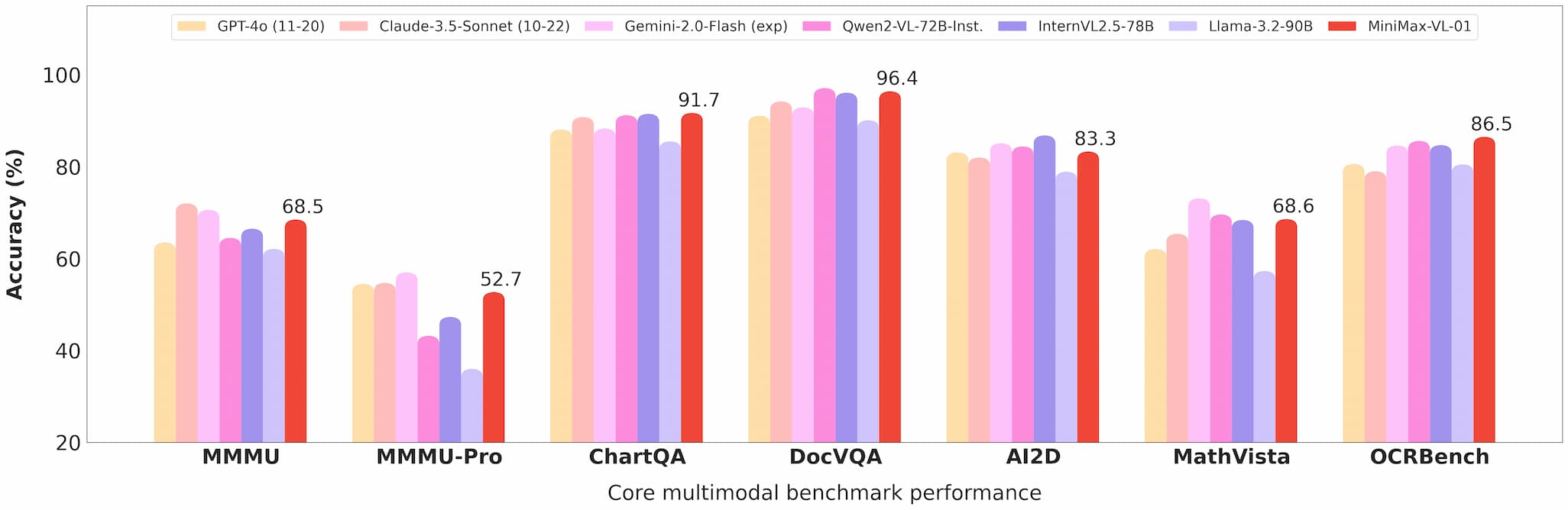

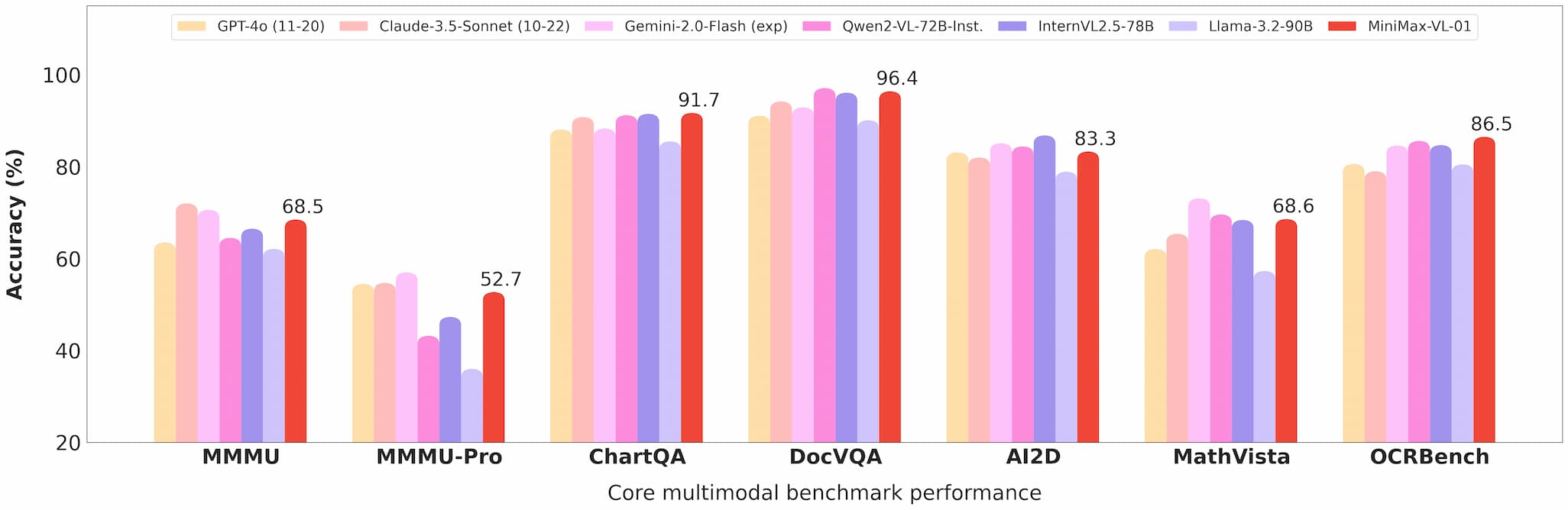

MiniMax-VL-01 excelle dans des tâches comme la réponse visuelle à des questions (VQA) et la légende d'images, démontrant de solides performances dans des benchmarks académiques et réels.

Benchmark vision Minimax 01

Efficacité des coûts

Avec des prix d'API à 0,2 $ par million de tokens d'entrée et 1,6 $ par million de tokens de sortie, Minimax offre une valeur inégalée pour les développeurs.

Commercialisation et open source

Accès à l'API

Les modèles sont disponibles via la plateforme Minimax Open Platform, avec des prix compétitifs et des mises à jour régulières.

Les développeurs peuvent intégrer ces modèles dans leurs applications facilement, grâce à une documentation complète et un support.

Open source

Minimax a rendu open source les poids complets des deux modèles sur GitHub et Hugging Face, encourageant les contributions de la communauté et la recherche.

Applications

Agents d'IA

La capacité à gérer des contextes longs rend ces modèles idéaux pour construire des systèmes de mémoire persistante et des cadres de communication multi-agents.

Tâches multimodales

De l'imagerie médicale à la conduite autonome, les capacités de MiniMax-VL-01 ouvrent de nouvelles possibilités pour les industries nécessitant une compréhension avancée du langage visuel.

Solutions rentables

L'API à faible coût rend ces modèles accessibles aux startups et aux petites entreprises, démocratisant l'accès à la technologie de pointe en IA.

Retours d'utilisateurs et tests réels

Les premiers utilisateurs ont salué la série MiniMax-01 pour ses performances et sa polyvalence :

- Les développeurs ont rapporté une intégration fluide et des améliorations significatives dans des tâches comme le résumé de documents et la génération de contenu multimodal.

- Les chercheurs apprécient la nature open source des modèles, permettant la personnalisation et l'expérimentation.

Perspectives futures

Minimax envisage un avenir où les agents d'IA et les systèmes multimodaux seront omniprésents. La série MiniMax-01 est un pas vers cette vision, offrant les outils nécessaires pour construire des applications d'IA complexes et à contexte long.

Conclusion

La série MiniMax-01 est plus qu'une réussite technologique ; c'est un catalyseur pour l'innovation dans la communauté de l'IA. Avec son traitement de contexte long sans précédent, ses capacités multimodales et son efficacité en termes de coûts, cette série est en train de redéfinir ce qui est possible dans le développement de l'IA.

Pour les développeurs souhaitant rester à la pointe, la série MiniMax-01 est une exploration incontournable. Visitez la plateforme Minimax Open Platform ou consultez le dépôt GitHub pour commencer dès aujourd'hui.

Références

Pour les développeurs souhaitant approfondir la série MiniMax-01, les ressources suivantes sont inestimables :